Aprenda definitivamente a trabalhar com CSS Grid com este Guia Interativo para facilitar o seu traba...

Aprenda a trabalhar com o CSS Flexbox com este guia definitivo e interativo! Vamos ver primeiro as p...

Você já ouviu falar de Docker e de containers? Você sabe a real diferença entre containers Docker e...

Confira neste artigo o que vem a ser um container.

Conheça as camadas e componentes do padrão arquitetural Porto. Nesse artigo vamos aprender como cada...

Com o lançamento do WSL 2, agora é possível executar o Docker sem precisar de uma máquina virtual tr...

Preparar nosso ambiente local de desenvolvimento pode ser uma tarefa bastante demorada. Pode levar h...

Dando sequência aos artigos sobre Injeção de Dependência e Container de Injeção de Dependência, ness...

Conheça mais sobre o OpenShift e como ele funciona.

Você sabe o que vem a ser o Kubernetes e como ele pode nos ajudar? Confira neste artigo.

Neste artigo veremos algumas das abordagens e widgets que são usados no desenvolvimento de aplicativ...

Conheça o padrão arquitetural Porto! Voltado para aplicações back-end, ele permite escrever monolito...

O Java define a especificação JAX-RS API para a criação de aplicações API RESTful, que pode ser faci...

Nesse artigo uma introdução à arquitetura Serverless e um pouco sobre o AWS Lambda, um dos principai...

Confira neste artigo quais são as tendências de tecnologia para este ano.

Nesse guia completo veremos como funciona e quais as formas de criar estilizações com CSS, necessári...

Instalar Bootstrap via npm e alterar suas variáveis, é mais simples do que imagina. Hoje iremos junt...

Uma Introdução ao Swoole, framework PHP assíncrono baseado em corrotinas e comparação dele com o mod...

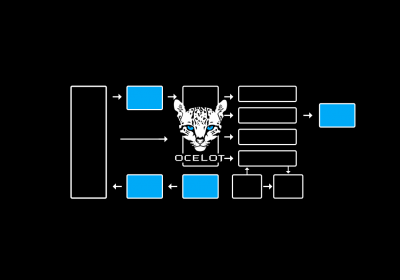

Conheça o conceito de API Gateway e veja como criá-lo em uma aplicação ASP.NET utilizando a bibliote...

Você sabe o que é DevOps? Confira neste artigo.