Aprenda o que é gRPC e como criar um serviço com esta tecnologia no ASP.NET Core.

Conheça os principais serviços gratuitos do Google Cloud Platform e seus limites de uso.

A aplicação de tecnologias geram resultados concretos para as organizações. A arquitetura SOA é um b...

Veja alguns dos serviços oficiais de hospedagem e teste gratuito de algumas das principais plataform...

A ação de usuários disparam diversos serviços que podem falhar ou ficar indisponíveis. Conheça neste...

Conheça o padrão arquitetural Porto! Voltado para aplicações back-end, ele permite escrever monolito...

Vamos conhecer nesse artigo o que é um CDN, como ele funciona, quais suas vantagens e os principais...

Veja como Stream Wrappers personalizados podem ser criados em PHP para se trabalhar com streams usan...

Nesse artigo uma introdução à arquitetura Serverless e um pouco sobre o AWS Lambda, um dos principai...

O Google Cloud Platform é o serviço de computação em nuvem do Google. Ele possui uma quantidade enor...

Veja as principais novidades e atualizações que a equipe de desenvolvedores do Android Studio prepar...

A Amazon Web Services (AWS) é uma das principais plataformas de computação em nuvem do mercado. Apre...

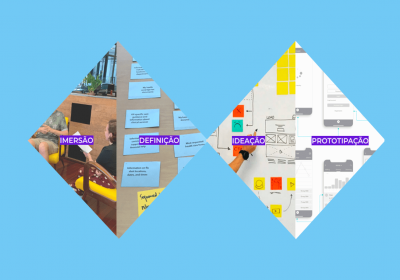

Confira neste artigo o que vem a ser o Design Thinking e quais são suas etapas.

Na terça-feira de carnaval, vários sites e aplicativos que utilizam a AWS enfrentaram uma brusca int...

Conheça o compute engine e veja como criar novas instâncias de VM no Google Cloud Platform.

Você sabe realmente como deve funcionar e como proteger um serviço SOA? Veremos nesse artigo como pr...

Neste artigo abordaremos o que é o Double Diamond e suas etapas, que vão da imersão até ao protótipo...

Conheça o que é design inclusivo, seus princípios e a importância de pensar em acessibilidade em seu...

Continuando com nossa série de artigos sobre os termos comuns de segurança, vamos abordar hoje o DDo...

Nesse artigo vamos aprender como publicar e configurar um projeto desenvolvido em ASP.NET Core 3.0 n...