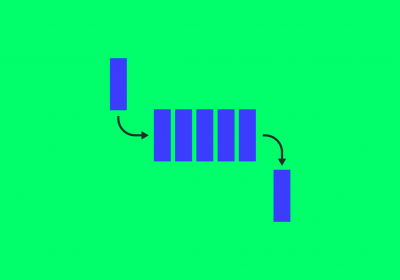

Veja neste artigo o que é e como funciona a Estrutura de Dados Fila.

Veja neste artigo o que é e como funciona a Estrutura de Dados Pilha.

Veja neste artigo o que é e como funciona a Estrutura de Dados Lista.

Veja neste artigo como utilizar o Django para mapear toda estrutura de um banco de dados existente e...

Veja neste artigo o que é Banco de Dados.

Neste artigo iremos conhecer quais são, como podemos declarar e como utilizar as principais estrutur...

Aprenda a criar uma estrutura de pastas e arquivos com React para ter uma aplicação com fácil manute...

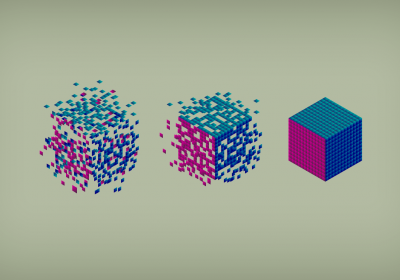

Confira neste artigo o que são dados estruturados, não estruturados e semiestruturados.

No Python, as principais estruturas são as Listas, Sets, Dicionários e Tuplas e neste artigo veremos...

Valores em PHP possuem que semântica? De valor ou de referência? Objetos são passados por referência...

Streaming não se resume apenas a conteúdo de media. Aprenda neste artigo como criar uma streaming AP...

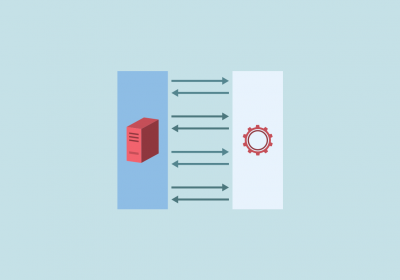

Exemplo de como criar uma aplicação ASP.NET MVC utilizando ADO.NET como framework de acesso aos dado...

Conheça neste artigo os tipos de dados presentes no C# e a sintaxe para que possamos declarar variáv...

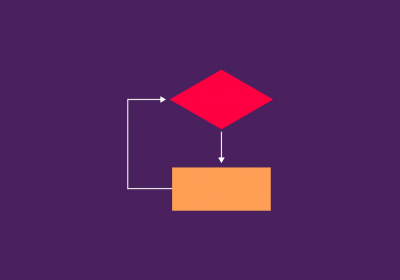

O loop foreach no PHP é uma estrutura de repetição simples e flexível! Aprenda corretamente como uti...

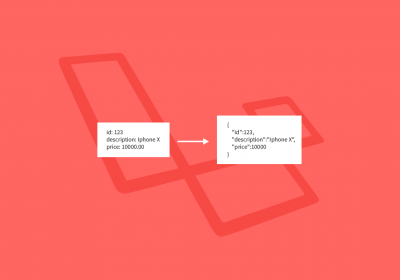

Um dos pontos mais importantes quando estamos trabalhando APIs é o retorno dos dados. Veja como melh...

Nesse artigo falaremos um pouco sobre o que é serialização de dados e quais os principais recursos q...

Veja o exemplo de uma aplicação ASP.NET Core acessando os dados de um servidor cluster definido com...

Neste artigo iremos falar sobre o que é, qual a estrutura e onde são utilizados os JSON Web Tokens o...

Veja neste artigo o que é um Sistema de Gerenciamento de Banco de Dados (SGBD).

O Doctrine é um conjunto de projetos PHP voltados principalmente para trabalhar com persistência de...